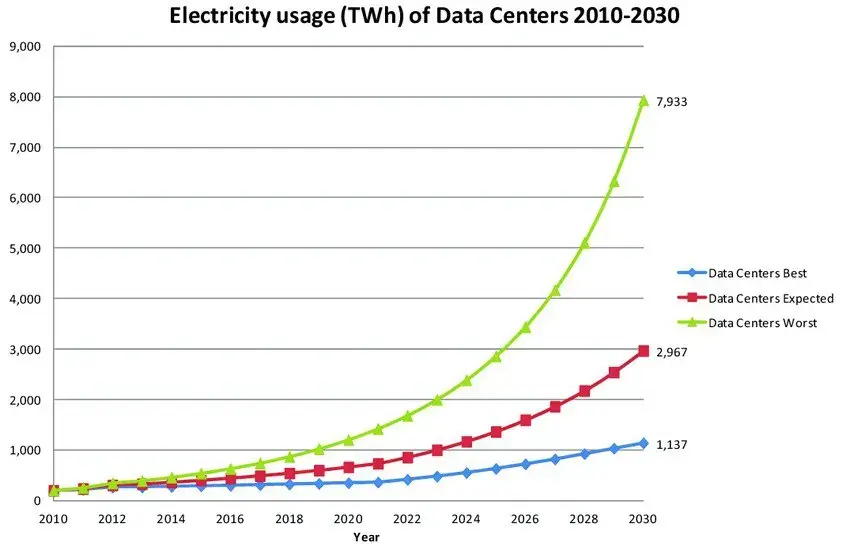

Современная цифровая экономика невозможна без дата-центров и серверных помещений, однако их энергопотребление с каждым годом растёт все активнее - по данным исследований 2024 года, глобальная индустрия дата-центров потребляет около 200-250 ТВт·ч электроэнергии ежегодно, что составляет примерно 1% от общемирового энергопотребления. Еще более показательными являются прогнозы: эксперты прогнозируют рост энергопотребления дата-центров до 3-8% от глобального потребления к 2030 году, что связано с развитием искусственного интеллекта, машинного обучения и растущим объемом обрабатываемых данных. Один современный дата-центр среднего размера потребляет от 10 до 50 МВт электроэнергии — это сопоставимо с энергопотреблением небольшого города.

График ожидаемого роста энергопотребления дата-центров

Проблема энергоэффективности дата-центров имеет два критически важных измерения. С экологической точки зрения, высокое энергопотребление серверных инфраструктур напрямую влияет на углеродный след компаний и глобальные климатические изменения. Многие страны вводят углеродные налоги и требования по снижению выбросов CO2, что делает энергоэффективность не просто желательной, но обязательной характеристикой современного бизнеса.

С экономической стороны, затраты на электроэнергию могут составлять от 20% до 40% общих операционных расходов дата-центра. Для средней компании с собственной серверной инфраструктурой счета за электричество превращаются в серьёзную статью расходов - при этом исследования показывают, что правильно спланированные мероприятия по повышению энергоэффективности способны снизить энергопотребление на 20-50% без ущерба для производительности. Первым и наиболее важным шагом на пути к энергоэффективности является детальный анализ текущего энергопотребления. Без понимания того, где и как расходуется энергия, невозможно принимать обоснованные решения по оптимизации.

Методы мониторинга энергопотребления

Современный рынок предлагает широкий спектр решений для мониторинга энергопотребления серверных помещений. Интеллектуальные PDU (Power Distribution Units) позволяют отслеживать потребление электроэнергии на уровне отдельных розеток и серверных стоек. Эти устройства предоставляют данные в реальном времени о напряжении, токе, мощности и коэффициенте мощности. Более комплексное решение - это системы DCIM (Data Center Infrastructure Management), которые интегрируют данные от различных источников — от PDU до датчиков температуры и влажности — в единую платформу управления. Такие решения, как Schneider Electric EcoStruxure IT, HPE OneView или Dell OpenManage Enterprise, позволяют получить комплексное представление об энергопотреблении инфраструктуры.

Интерфейс DCIM системы HPE OneView

Также, выявить энергоемкие процессы и приложения можно и с помощью специальных инструментов, доступных в серверных операционных системах. PowerTOP для Linux или встроенные средства Windows Server позволяют анализировать энергопотребление отдельных компонентов системы.

Использовать полученную информацию и определить, какова ситуация с энергопотреблением в вашем дата-центре или серверной комнате, поможет расчет одной ключевой метрики, отражающей эффективность использования энергии - PUE.

Метрика PUE и её практическое применение

PUE (Power Usage Effectiveness) является ключевой метрикой для оценки энергоэффективности дата-центров. Она рассчитывается как отношение общего энергопотребления объекта к энергопотреблению IT-оборудования:

PUE = Общее энергопотребление дата-центра / Энергопотребление IT-оборудования

Идеальное значение PUE равно 1.0, что означает, что вся потребляемая энергия используется непосредственно IT-оборудованием. На практике типичные значения PUE составляют:

-

Отличный уровень: 1.2-1.3

-

Хороший уровень: 1.3-1.5

-

Средний уровень: 1.5-2.0

-

Неэффективный уровень: выше 2.0

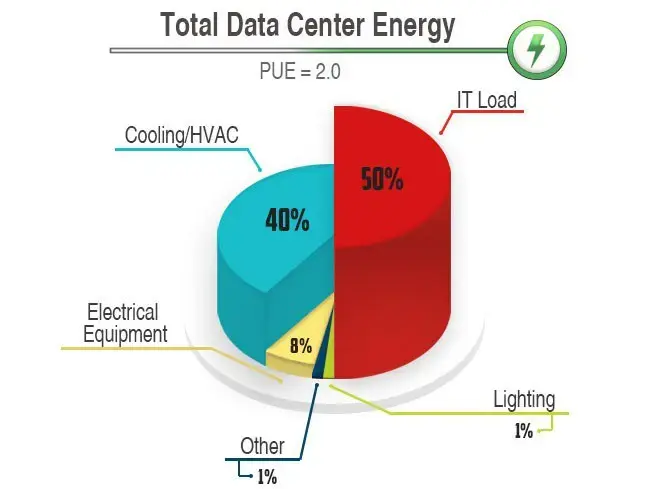

Пример распределения энергии в дата-центре с показателем PUE = 2.0

Важно отметить, что PUE следует измерять регулярно и в различных условиях нагрузки, поскольку эффективность систем охлаждения и электропитания может значительно изменяться в зависимости от загрузки и внешних условий.

За примером хорошего показателя PUE, достигнутого в том числе благодаря эффективному применению DCIM-мониторинга, не нужно далеко ходить. Крупный дата-центр Xelent, расположенный в Санкт-Петербурге, в 2021 году смог добиться среднегодового показателя PUE в 1,28 – можно с уверенностью сказать, что это один из самых низких показателей в России. В среднем PUE в российских дата-центрах колеблется в диапазоне от 1,5 до 1,7. Помимо DCIM-мониторинга, высокая энергоэффективность ЦОД Xelent была достигнута за счёт оптимизации инженерных систем.

Дата-центр Xelent

Оптимизация систем охлаждения

Важным шагом на пути к повышению энергоэффективности является оптимизация систем охлаждения оборудования. Системы охлаждения являются одним из крупнейших потребителей энергии в дата-центрах, часто составляя 30-40% от общего энергопотребления, как мы в том числе видели на графике выше. Эффективная оптимизация может обеспечить значительную экономию энергии без ущерба для надежности оборудования. Именно о способах сократить расходы энергии на охлаждение мы подробно будем рассказывать далее - но сначала давайте упомянем ещё два крайне важных момента, без которых усилия по оптимизации охлаждения могут оказаться малополезны.

Оптимальная температура серверной

В первую очередь, необходимо точно определить оптимальную температуру помещения, где размещается оборудование - традиционно многие дата-центры поддерживали температуру в диапазоне 18-21°C, исходя из консервативного подхода к обеспечению надежности. Однако современные исследования и рекомендации показывают, что современное серверное оборудование может надежно работать при температурах до 27°C.

Повышение температуры на каждый 1°C может снизить энергопотребление систем охлаждения на 4-6%. Таким образом, повышение температуры с 20°C до 25°C может привести к снижению затрат на охлаждение на 20% и более. При этом, все же не стоит забывать и про рекомендации производителей оборудования и обеспечивать равномерное распределение температуры по всему серверному помещению. К слову о распределении - в данном контексте нельзя не упомянуть про правильное расположение стоек с оборудованием.

Правильная организация серверных стоек

Архитектура «горячий коридор — холодный коридор» является стандартом современных энергоэффективных дата-центров. При такой организации серверные стойки располагаются рядами таким образом, что воздухозаборники серверов направлены в одну сторону (холодный коридор), а выходы горячего воздуха — в противоположную (горячий коридор).

Чтобы обеспечить максимальную эффективность в рамках данной архитектуры, стоит обратить внимание на несколько важных факторов:

-

Изоляцию горячих коридоров с помощью потолочных панелей или дверей, что предотвращает смешивание горячего и холодного воздуха

-

Герметизацию неиспользуемых слотов в стойках специальными заглушками

-

Правильную прокладку кабелей, не создающую препятствий для воздушных потоков

-

Равномерное распределение нагрузки между стойками для предотвращения локальных тепловых точек

Методы свободного охлаждения

Возвращаясь к теме методов охлаждения и их оптимизации, позволяющей заметно сократить итоговое энергопотребление, в первую очередь нужно сосредоточится на системах свободного охлаждения. Такие системы используют наружный воздух для охлаждения дата-центра, когда его (воздуха) температура ниже температуры внутри помещения. Существует два основных типа экономайзеров:

-

Воздушные экономайзеры напрямую используют наружный воздух для охлаждения. Они наиболее эффективны в регионах с умеренным климатом и могут обеспечить до 50-70% годовой экономии энергии на охлаждение. Однако их применение ограничено качеством наружного воздуха и климатическими условиями.

-

Водяные экономайзеры используют наружный воздух для охлаждения воды в системах чиллеров. Они более универсальны и могут работать в более широком диапазоне климатических условий, обеспечивая экономию энергии на уровне 20-40%.

Показательным примером эффективного использования свободного охлаждения является опыт Meta* (запрещена в РФ), связанный с их дата-центром в Лулео (Швеция). Построенный в 2013 году, этот ЦОД использует наружный воздух для охлаждения более 95% времени в году благодаря холодному скандинавскому климату.

Дата-центр в Лулео

Инженеры этого ЦОД разработали инновационную систему, которая фильтрует и кондиционирует наружный воздух, подавая его непосредственно в серверные залы. Система включает многоступенчатую фильтрацию, контроль влажности и автоматическое переключение на традиционное механическое охлаждение только в периоды высоких температур. Результаты действительно впечатляют - PUE дата-центра в Лулео составляет 1,07 — один из лучших показателей в индустрии. По различным оценкам, годовые затраты на охлаждение удалось снизить на 85% в сравнении с традиционными дата-центрами, что экономит компании миллионы долларов ежегодно.

Жидкостное охлаждение - возможности и ограничения

Система жидкостного охлаждения оборудования. Источник: Green Revolution Cooling

Помимо возможностей систем свободного охлаждения, не стоит забывать и про все более популярную альтернативу стандартным методам воздушного охлаждения - речь, конечно же, про жидкостное охлаждение. Оно весьма эффективно при работе с высокопроизводительными серверами и системами с высокой плотностью размещения. Основных типов жидкостного охлаждения, как и в предыдущем случае, тоже два:

Непрямое жидкостное охлаждение использует замкнутый контур с охлаждающей жидкостью, которая циркулирует через радиаторы, установленные на процессорах. Такие системы могут снизить количество энергии, затрачиваемое на охлаждение на 10-20% и позволяют размещать серверы с большей плотностью.

Погружное охлаждение предполагает полное погружение серверного оборудования в диэлектрическую жидкость. Этот метод обеспечивает исключительно эффективное охлаждение и может снизить энергопотребление систем на 40%. На сегодняшний день жидкостное и погружное охлаждение начинает все активнее использоваться в обычных ЦОД, хотя ранее использовалось преимущественно в крупнейших дата-центрах транснациональных корпораций или для охлаждения суперкомпьютеров. Кстати, один из пионеров в области погружного охлаждения - компания Green Revolution Cooling - внедряла свои разработки (технологию CarnotJet) как раз таки в рамках проекта по погружному охлаждению суперкомпьютера TSUBAME KFC Токийского института технологий GSIC. На момент запуска проекта (а было это в уже столь далеком 2014 году) это был самый энергоэффективный суперкомпьютер на планете, лидер рейтинга Green500. Тем не менее, погружное охлаждение по прежнему остается самым эффективным методом охлаждения для оборудования с предельными вычислительными мощностями - например, для эффективной работы современного суперкомпьютера Lonestar6, расположенного в Техасском центре передовых компьютерных методов (Texas Advanced Computing Center), используется одностадийное погружное охлаждение GRC ICEraQ. В результате показатель PUE всей установки составляет около 1,10, что является отличным результатом.

Суперкомпьютер Lonestar6

Кроме того, помимо снижения энергопотребления, у жидкостного охлаждения можно отметить и другие плюсы - в первую очередь, значительное снижение уровня шума (поскольку нет необходимости в мощных вентиляторах) и возможность увеличения плотности размещения оборудования в 3-4 раза. Однако нельзя отрицать и недостатки такого метода охлаждения - сложность обслуживания оборудования, необходимость специальной подготовки персонала и высокие первоначальные затраты на модернизацию инфраструктуры. Поэтому, справедливо будет сказать, что несмотря на возрастающую популярность, жидкостное охлаждение пока остается нишевым решением. Кстати, раз уж речь зашла про модернизацию инфраструктуры - здесь свои бонусы для энергоэффективности может дать не только система охлаждения. А если вам все же хочется узнать про PUE и специфику охлаждения серверов во всех подробностях - у нас есть лонгрид на Хабре на данную тему.

Модернизация оборудования и альтернативные технологии

Замена устаревшего оборудования на современные энергоэффективные решения также является одним из наиболее эффективных способов снижения энергопотребления серверных инфраструктур. Современные технологии предлагают значительные улучшения в энергоэффективности по сравнению с оборудованием даже четырех-пятилетней давности. Давайте разберемся, что именно обновлять для максимального влияния на энергоэффективность.

Серверы стандарта ENERGY STAR обеспечивают на 20-30% более высокую энергоэффективность по сравнению с базовыми моделями. Стандарт ENERGY STAR для серверов устанавливает требования к эффективности блоков питания (не менее 80% при различных уровнях нагрузки) и активным режимам управления питанием. Также, говоря о современном оборудовании, следует отметить, что современные серверные процессоры Intel Xeon и AMD EPYC последних поколений используют техпроцессы 7нм и 5нм, что обеспечивает значительно более высокую производительность на ватт по сравнению с предыдущими поколениями. Например, процессоры Intel Xeon Sapphire Rapids демонстрируют улучшение энергоэффективности на 40-50% по сравнению с моделями 2018 года.

Системы бесперебойного питания (ИБП) нового поколения также являются важным фактором достижения оптимального уровня энергоэффективности. Современные ИБП с технологией двойного преобразования достигают КПД 96-98% по сравнению с 90-93% у моделей предыдущего поколения. ИБП с режимом ECO или технологией VFI (Voltage and Frequency Independent) могут работать с КПД до 99% при определенных условиях.

Переход с жестких дисков (HDD) на твердотельные накопители (SSD) тоже обеспечивает значительную экономию энергии. Типичный серверный HDD потребляет 6-10 Вт в активном режиме, в то время как SSD потребляет 2-4 Вт. При этом SSD обеспечивают значительно более высокую производительность, что позволяет сократить количество серверов, необходимых для выполнения тех же задач.

SSD Samsung PM9A3. Источник изображения: Samsung

NVMe SSD последнего поколения, особенно с интерфейсом PCIe 4.0 и 5.0, обеспечивают исключительно высокую производительность при относительно низком энергопотреблении. Современные enterprise SSD, такие как Samsung PM9A3 или Intel D7-P5510, потребляют всего 1.5-3 Вт при обеспечении производительности в сотни тысяч IOPS.

Частичный переход на облачные решения

Ещё один эффективный способ экономии энергии - это гибридные облачные архитектуры. Они позволяют компаниям оптимизировать энергопотребление за счет размещения переменных рабочих нагрузок в публичных облаках, которые обладают более высокой энергоэффективностью благодаря масштабу и специализации.

Крупные облачные провайдеры, такие как AWS, Microsoft Azure и Google Cloud, достигают PUE на уровне 1.1-1.2 благодаря инвестициям в энергоэффективные технологии охлаждения, возобновляемые источники энергии и оптимизированное оборудование. Для многих предприятий перенос части рабочих нагрузок в облако может быть более энергоэффективным решением, чем поддержание собственной инфраструктуры.

Если говорить о примере успешного переноса части вычислительных мощностей в облако - весьма интересным примером, связанным ещё и с технологиями IIoT и цифровых двойников (кстати, про обе темы у нас есть свежие статьи на Хабре - переходите по ссылкам чтобы узнать больше) будет опыт компании Coca Cola, а точнее - подразделения, ответственного за бутилирование продукции. Компания столкнулась с высокими энергозатратами на производственных объектах, где традиционные серверные решения потребляли значительные ресурсы для управления промышленными системами (SCADA, MES) и анализа данных в реальном времени. В результате, было принято решение разработать платформу цифровых двойников (digital twins) на базе облачной инфраструктуры AWS

-

AWS IoT SiteWise для сбора данных с датчиков оборудования (энергопотребление, температура, вибрация).

-

AWS IoT Analytics и машинное обучение для прогнозирования пиковых нагрузок и оптимизации режимов работы охлаждающих систем, компрессоров и насосов.

Критические системы были сохранены на локальном уровне, в то время как аналитика и управление энергопотоками перенесены в облако, что в конечном итоге позволило сократить энергопотребление и снизить затраты на электроэнергию на двух ключевых производственных линиях на 20%. В итоге, компания сэкономила более 1 млн. долларов в год.

Управление питанием неиспользуемого оборудования

Прежде чем перейти к рассказу о методах управления питанием неиспользуемого оборудования, нужно сделать краткую ремарку о том, что именно подразумевается под словом “неиспользуемое” - в данном случае речь идет о так называемых «зомби-серверах».

«Зомби-серверы» — это физические серверы, которые потребляют энергию, но при этом не выполняют полезной работы — вполне могут составлять до 10-15% от общего парка серверов в типичной организации. Даже неиспользуемый сервер в режиме простоя может потреблять до 40% от максимальной мощности, что несет за собой немалые затраты на его питание.

Чтобы избежать ненужных расходов на электроэнергию, можно использовать системы автоматизированного управления питанием - они позволяют выявлять и автоматически отключать такие серверы. Современные решения включают:

-

Wake-on-LAN и удаленное управление питанием через IPMI, iLO, iDRAC позволяют автоматически включать серверы при необходимости и отключать их в периоды простоя.

-

Интеллектуальные PDU с возможностью удаленного управления каждой розеткой позволяют автоматически отключать питание неиспользуемого оборудования по расписанию или на основе данных мониторинга.

-

Программные решения для управления питанием, такие как Microsoft System Center или VMware vRealize Operations, могут автоматически переводить виртуальные машины в спящий режим или мигрировать их на меньшее количество физических хостов в периоды низкой нагрузки.

В дополнение стоит сказать о технологиях автоматического масштабирования, таких как Kubernetes Horizontal Pod Autoscaler или AWS Auto Scaling, которые позволяют динамически изменять количество активных вычислительных ресурсов в зависимости от текущей нагрузки - о них мы ещё обязательно расскажем подробнее в будущих статьях.

Заключение

Энергоэффективность серверных инфраструктур представляет собой комплексную задачу, требующую системного подхода и постоянного внимания. Рассмотренные в статье методы и технологии демонстрируют, что значительное снижение энергопотребления — до 30-50% — достижимо при правильном планировании и реализации. Что даже более важно - высокая энергоэффективность серверных инфраструктур экономически выгодна организациям, комплексный подход к оптимизации энергопотребления позволяет компаниям значительно снизить операционные расходы и повысить устойчивость бизнеса. Надеемся, что наша статья была полезной для всех, кто стремится оптимизировать энергопотребление своих IT-инфраструктур - а нам остается лишь ещё раз вспомнить о том, что энергоэффективность — это непрерывный процесс совершенствования, который требует внимания, но при этом обеспечивает устойчивые результаты и долгосрочные конкурентные преимущества.

Нажимая кнопку «Отправить», я даю согласие на обработку и хранение персональных данных и принимаю соглашение