Ранее в нашем блоге выходила статья с советами по выбору виртуалки и про ценообразование хостинг-провайдеров. Но не всем подходят облачные решения из-за проблем с функционалом, конфиденциальностью и безопасностью. Тогда компании принимают решение создать своё — родное, куда никто не залезет и ничего не испортит. Об этом и поговорим :)

Эта статья подойдет всем, кто решил создать или модернизировать собственную IT-инфраструктуру для виртуализации. Здесь будут конкретные советы по подбору физического сервера виртуализации, но без углублений в софт.

Что такое виртуализация серверов

Виртуализация серверов — это программное разделение сервера (компьютера) на несколько независимых и изолированных друг от друга виртуальных машин (ВМ). Если по-простому, это некая шкатулка, внутри которой есть несколько отсеков под хранение разных или одинаковых вещей.

Сервер, который разбивается на виртуалки, называется хост-машиной (шкатулка), а виртуальные машины, которые получились в результате, называются гостевыми машинами (все внутренние отсеки).

Во главе всего процесса находится гипервизор, который бывает нескольких видов:

-

Гипервизор 1-го типа — bare-metal («голый металл») или аппаратный гипервизор. Примеры: ESXi, KVM, Hyper-V, Xen — сегодня KVM и VMware ESXi де-факто стандарт в корпоративной виртуализации.

Гипервизор 1-го типа работает напрямую на аппаратном обеспечении (без посредников). Операционная система (ОС) хоста сама является частью гипервизора или работает поверх него в специальном разделе (parent partition)

Между виртуальной машиной и железом сервера только одна прослойка — гипервизор

-

Гипервизор 2-го типа — хостовый гипервизор (примеры: VirtualBox, VMware Workstation, QEMU, Parallels Desktop для Mac). Такой гипервизор работает как приложение внутри обычной операционной системы хоста.

Ремарка!

Я не упомянул популярный Proxmox VE — и вот почему.

Иногда его относят к гипервизорам первого типа, ведь он работает поверх KVM (тип 1) и контейнеризации LXC. А иногда ко второму типу, ведь это даже не гипервизор как таковой, а виртуализационная платформа (надстройка над гипервизором), которая больше про оркестрацию, чем про роль хостового гипервизора. В общем, тема дискуссионная. В нашем блоге есть подробный материал про него.

Между виртуальной машиной и железом сервера две прослойки — операционная система и гипервизор

Есть и 3-ий — гибридный тип гипервизоров. Это неофициальный термин, которым комьюнити описывает гипервизоры с признаками 1-го и 2-го. Как правило основа (движок) гибридных гипервизоров работает как у первого типа, а администрирование идёт через обычную ОС, как у второго.

В пример часто приводят Hyper-V в составе Windows Server (или Windows 10/11 Pro и Enterprise): движок находится на низком уровне, а управляющая оболочка работает как роль/компонент внутри ОС. Путаница возникает потому, что при установке всё выглядит так, будто вы устанавливаете компонент в уже развёрнутую Windows (а, например, ESXi устанавливается как отдельная ОС).

Но сколько бы админы не спорили на форумах, архитектурно Hyper-V — это гипервизор 1-го типа: при загрузке сервера или рабочей станции первым загружается именно он — и получает прямой доступ к железу; затем он создает специальную привилегированную виртуальную машину «Родительский раздел» (Parent Partition); а ваша основная ОС (например, Windows Server) запускается уже внутри этого раздела. Вам кажется, что вы работаете на обычной ОС, но на деле прямого доступа к железу у неё нет (всё происходит через гипервизор Hyper-V).

Такие дела.

Гипервизор позволяет создавать ВМ, изолировать их друг от друга и распределять ресурсы сервера, благодаря чему каждая виртуальная машина может работать как полноценный компьютер со своей операционной системой и приложениями. Этот принцип лежит в основе облачных вычислений и гибридных IT-инфраструктур.

Актуальные гипервизоры в 2026 году (у нас в блоге есть обзоры):

-

VMware ESXi (vSphere) — основная корпоративная платформа. После поглощения VMware компанией Broadcom лицензирование сильно изменилось: теперь акцент на подписке и пакетных предложениях для крупного бизнеса.

-

Proxmox VE — стал популярным выбором для малого и среднего бизнеса благодаря поддержке LXC и KVM, удобному веб-интерфейсу и отсутствию лицензий (есть различные уровни поддержки платной, но это опционально).

-

Microsoft Hyper-V в составе Windows Server остаётся актуален, но чаще используется в смешанных инфраструктурах.

-

KVM — встроен в большинство Linux-дистрибутивов и активно используется даже в гипермасштабируемых средах.

Xen — чаще встречается в инфраструктуре крупных хостинг-провайдеров и у AWS.

Если провести аналогию, то системный администратор — это мастер по дереву, а гипервизор — его резец. С его помощью он вытачивает шкатулку, создаёт в ней отсеки нужного размера и формы, распределяя материал с точностью до миллиметра.

Преимущества виртуализации серверов

Опираясь на глоссарий VMware, назову основные плюсы серверной виртуализации, но чуть расширю, исходя из опыта. Это база, которая не меняется годами:

-

Виртуализация снижает риск сбоев, а если неполадки всё-таки происходят, виртуальные машины восстанавливаются заметно быстрее. В итоге инфраструктура работает стабильнее и дольше без остановки;

-

Обслуживание обходится дешевле (и проще), потому что физической техники становится меньше, и её легче приводить в порядок;

-

Инфраструктура уплотняется — на один сервер (или кластер) помещается больше рабочих нагрузок, и парк оборудования перестаёт расти бесконтрольно;

-

Виртуальные машины легко переносить, клонировать и изменять на лету — без остановки работы;

-

Развёртывание новой среды — тестовой, рабочей или промежуточной — занимает секунды или минуты, особенно если настроены шаблоны. Это куда быстрее, чем поднимать отдельный физический сервер.

От себя к этому списку добавлю ещё два важных преимущества:

Энергоэффективность. Консолидация виртуальных машин на меньшем количестве физических серверов резко снижает энергопотребление стоек. Это заметно экономит электричество и уменьшает тепловую нагрузку на серверную.

Отказоустойчивость. Современные платформы виртуализации умеют держать нагрузку даже при отказе отдельных узлов: виртуальные машины переносятся на рабочие хосты автоматически (если настроено), без паузы в работе сервисов.

Зачем нужна виртуализация серверов

Виртуализация серверов позволяет эффективнее использовать IT-инфраструктуру. В своей статье “Как выбрать сервер для 1С” я делал вкусную аналогию между виртуализацией и пиццей :) Она очень наглядна и легка в восприятии, поэтому я не буду изобретать каменную печь, а сделаю схожее сравнение.

5 причин, для чего нужна виртуализация серверов:

1) Чтобы сэкономить

|

Пицца |

Виртуализация |

|

Заказать большую пиццу на компанию всегда выгоднее по деньгам, чем несколько маленьких каждому по отдельности. |

Производительный сервер или кластер с ВМ окажется выгоднее в больших проектах, чем отдельные серверы под каждую задачу. И при правильном развёртывании будет ниже энергопотребление (это один из главных приоритетов в корпоративных дата-центрах). Серверы, вроде Dell, HPE и Lenovo, поддерживают интеллектуальные режимы энергосбережения на уровне BIOS и BMC (Baseboard Management Controller — аппаратный контроллер для удалённого управления сервером) через Redfish API. |

2) Чтобы использовать разные среды

|

Пицца |

Виртуализация |

|

Есть пиццы, которые совмещают сразу несколько начинок, например “4 сезона”.

На одной тестовой основе делают 4 любых вкуса: мясная, веганская, с томатным соусом, со сливочным, острая и т.д. |

Виртуализация позволяет сделать несколько ВМ, на которых можно развернуть разные операционные системы, их версии и несовместимый софт в рамках одного сервера. Часто ВМ используют как тестовые площадки для платформ и решений — быстро развернул, протестировал, закрыл.

Например, Windows и Linux запущенные на одном сервере. Сегодня виртуализацию часто сочетают с контейнерами (Docker, LXC, Kubernetes). Контейнеры не заменяют ВМ, а дополняют их: в ВМ изолируют инфраструктуру, а в контейнерах — приложения. Почти все современные платформы поддерживают гибридные сценарии (ВМ + контейнеры). |

3) Чтобы изолировать пользователей, их действия и данные друг от друга

|

Пицца |

Виртуализация |

|

Пицца, заказанная на компанию, не мешает вам взять любой кусок, достать из него весь лук и оливки, залить табаско, обмакнуть в майонез и съесть. И никто не запретит вам разрезать кусок на две части поделиться ещё с кем-то.

На других кусках это никак не скажется. |

Виртуализация позволяет изолировать пользователей друг от друга. Они могут хранить важные персональные данные и делать всё что угодно, хоть развернуть виртуализацию внутри виртуализации.

Другие пользователи даже не узнают об этом, так как все виртуалки полностью изолированы друг от друга. |

4) Чтобы не было простоев мощностей

|

Пицца |

Виртуализация |

|

Представьте, что вам очень захотелось любимой пиццы (легко, правда?), но она диаметром 50 см — слишком большая, чтобы съесть одному. Вам хватит всего 3-4 кусочка из 8, чтобы наесться от пуза.

К сожалению, остальным кускам придётся лежать в холодильнике до завтра, что не добавит баллов ко вкусу. |

Виртуализация позволяет избежать простоя мощностей, когда, например, из 100% возможностей сервера используется лишь небольшая часть.

Например, 10% ресурсов сервера выделены под почту, 30% под базы данных, а оставшиеся 60% под терминальный сервер. В 2026 году широко применяют динамическое распределение ресурсов (например, vSphere DRS, Proxmox HA, Live Migration). |

5) Чтобы равномерно распределить нагрузку между несколькими серверами

|

Пицца |

Виртуализация |

|

Например, вы голодны и заказали две пиццы по 25см каждую — себе и ребёнку. Свою съели быстро и не наелись, а ребёнок так объелся, что больше ходить не может :) Логичнее было бы разделить пиццы соразмерно голоду, а не покупать одинаковые пиццы под разные потребности. |

Виртуализация позволяет избежать неравномерного распределения нагрузки, когда, например, один сервер загружен на 20%, а два соседних в стойке на все 100% (и ещё куча задач в очереди). Когда несколько хостов объединены в кластер и работают через общую систему хранения — Ceph, vSAN, ZFS over iSCSI или аналогичные решения — нагрузка не привязывается жёстко к конкретному серверу. ВМ можно перемещать туда, где есть свободные ресурсы, без простоя. За счёт этого кластеры стабильнее, а ресурсы расходуются рационально. |

Надеюсь, вы не сильно проголодались, так что давайте двигаться дальше :)

Как выбрать сервер под виртуальные машины

Выбор оборудования для виртуализации не менее важен, чем выбор правильного ПО. Железо сильно влияет на гибкость и эффективность инфраструктуры, коэффициент консолидации, производительность, стоимость владения и доступность бизнес-приложений. Нерелевантные решения снижают прибыльность и ограничивают свободу действий.

А нам этого не надо, правда?

“Сервер” в коробке из-под обуви. Без комментариев.

Чтобы сэкономить, многие компании перепрофилируют оборудование, которое покупалось под другие задачи: ПК или старые серверы. Однако у этого подхода есть значительные минусы:

-

ПК не рассчитаны на беспрерывное обслуживание большого количества пользователей;

-

ПК и серверы, купленные под другие задачи, могут не подойти под будущий вертикальный рост (возможность заменить комплектующие на более мощные или добавить ещё ресурсов);

-

Маломощный процессор и малый объем памяти ухудшают производительность ВМ;

-

Недостаточное количество оперативной памяти ограничивает максимальное количество ВМ.

Для начала надо проработать задачу, определить, какой сервер нужен, а уже потом смотреть, подойдёт ли ваше оборудование. Тесты позволяют выявить слабые места уже через неделю-месяц.

Железо (bare metal) для виртуализации

Bare metal сервер от Dell

Сервер для виртуализации должен иметь хороший потенциал для вертикального масштабирования. Например, возможность установить второй процессор, добавить несколько дисков и планок оперативной памяти, поставить ещё одну сетевую карту в свободный слот расширения.

Бюджетные модели не могут похвастаться хорошей вертикальной масштабируемостью. Поэтому оптимальный сервер для виртуализации — это среднебюджетная модель в форм-факторе 2U и больше. Желательно в пределах двух последних поколений. При этом современные 1U серверы с SSD также отлично подойдут.

Например:

ПОДБОРКА СЕРВЕРОВ ДЛЯ ВИРТУАЛИЗАЦИИ

Если говорить о железе, то на производительность ВМ больше всего влияет четыре параметра: CPU, RAM, дисковая подсистема и сетевой адаптер.

Процессор для сервера виртуализации (CPU)

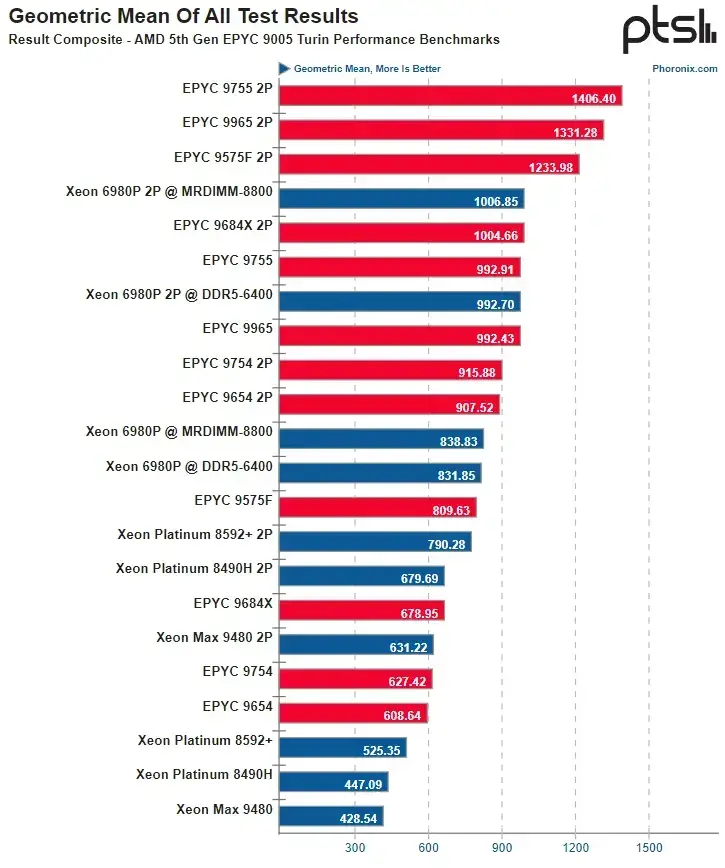

На рынке по-прежнему два главных производителя: Intel и AMD. Если сравнивать процессоры в одном ценовом сегменте, то в последнее время Intel отстаёт, а AMD лидирует. Из явных преимуществ Intel могу лишь отметить некоторые аппаратные блоки ускорения, а также расширения матричной математики AMX.

Актуальные серии на 2026 год:

-

Intel Xeon 6 (Granite Rapids и Sierra Forest) — новое поколение, пришедшее на смену Xeon Scalable 5. Поддержка DDR5, PCIe 5.0 и CXL 2.0.

-

AMD EPYC 9004 / 9005 (Genoa, Bergamo, Turin) — чипы на архитектуре Zen 4 и Zen 5. Поддерживают DDR5 и PCIe 5.0/6.0.

На 2026 год сказать, что кто-то лучше по всем параметрам, нельзя. Для объективной картины всё ещё нужно тестировать конкретное поколение, линейку и модель под свои задачи. Смотреть на одни лишь синтетические тесты — тоже неправильно, так как рабочие задачи менее предсказуемы, да и некоторое ПО до сих пор лучше работает на Intel.

Из-за высокой конкуренции Intel изменила стратегию в новом поколении Xeon 6 (и новее), отказавшись от бренда Scalable и разделив серверные процессоры на два основных направления для разных сегментов рынка: Sierra Forest — энергоэффективные ядра E, не самые производительные, зато отлично подходят для плотного размещения в ЦОДе (до 288 ядер на сокет) — виртуализации и облачных нагрузок; Granite Rapids — высокопроизводительные ядра для высокопроизводительных вычислений (до 128 ядер на сокет). Виртуализацию можно реализовать на обоих вариантах, но для большинства задач Sierra Forest c E-ядрами подходит лучше.

|

ВАЖНО! Но исторически сложилось так, что огромный пласт серверов в IT-индустрии годами работал на решениях Intel, особенно в корпоративных сегментах и ЦОДах. Из-за этого на вторичном рынке выбор куда шире, чем на AMD, а восстановленные серверы на Intel стоят крайне конкурентно (с учётом высокой надёжности и гарантий 5 лет, которую мы даём). У AMD в старших поколениях вариантов мало, но начиная с EPYC Rome и дальше предложение растёт, так что перекос постепенно исчезает, но пока он есть. |

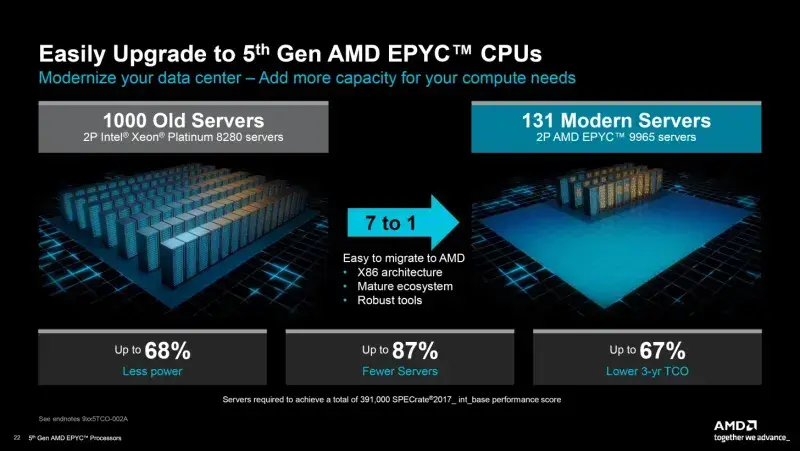

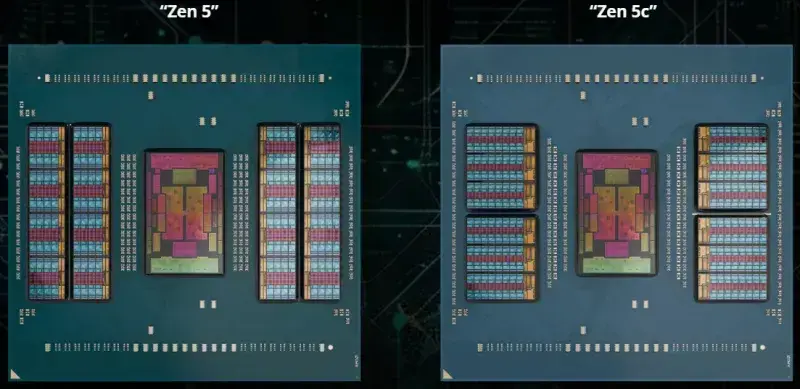

Теперь к AMD — свежие EPYC 9004/9005 получились крайне удачными: огромное количество ядер на сокет (до 128 ядер Zen 5, до 192 Zen 5c, следующее поколение 9006 получит до 256 ядер) — с высокой производительностью и тактовой частотой. По соотношению цена/производительность EPYC выигрывает у Xeon.

Но конкуренция влияет и на решения AMD: компания уже два поколения выпускает компактные версии микроархитектур Zen 4 и 5 (с индексом “c”). Например, Zen 5c — это второе поколение уменьшенных ядер AMD. По сути, те же вычислительные возможности и тот же набор инструкций, но в более плотной упаковке: ядро занимает примерно на четверть меньше площади. По позиционированию Zen 5c конкурирует с энергоэффективным решениям Intel, но AMD не меняла микроархитектуру — все ядра одинаковые, без разделения, как у Intel с P и E-ядрами.

|

ПОЛЕЗНО! AMD у себя на сайте до сих пор продвигает очень гибкий интерактивный калькулятор TCO (Total Cost of Ownership — совокупная стоимость владения), где можно сравнить любые процессоры EPYC и Intel Xeon для виртуализации. Там, разумеется, выигрывает AMD — всё же их калькулятор. Но факт в том, что если посчитать самому, то последние поколения EPYC и правда хорошо смотрятся по общей стоимости владения, особенно в задачах, которые масштабируются по ядрам. |

Чек-лист по выбору серверного процессора (CPU) для виртуализации

|

Параметр |

Примечание |

|

Совместимость платформы |

Проверяйте сокет, чипсет, поколение CPU. У разных поколений могут отличаться разъёмы и сокеты. Xeon 6, например, требует новую платформу Birch Stream (старые серверы не подойдут). Так что сначала проверяем платформу/базу/материнскую плату, а потом выбираем процессор. |

|

Количество ядер под вашу нагрузку |

Для виртуализации и контейнеризации важна плотность ядер и энергоэффективность. Отличный универсальный старт — 32–96 ядер. Всё, что выше, уже для облаков и крупных инфраструктур. |

|

Тактовая частота: базовая и в разгоне |

16 ядер на высокой частоте будут быстрее 64 энергоэффективных ядер (при прочих равных), особенно это заметно в приложениях, которые плохо оптимизированы для многопоточных нагрузок. Поэтому всегда исходите из задачи. Для виртуализации не всегда нужна высокая частота. |

|

Кэш: объём L3 и его структура |

Большой L3-кэш улучшает производительность в VDI, 1С, базах данных и аналитике. |

|

TDP (Тепловыделение и требования к охлаждению) / энергопотребление |

Чем выше TDP, тем выше требования к системе охлаждения и отводу тепла из помещения, где работает сервер. Современные многоядерные CPU (по 50, 100 и т.д. ядер) требуют мощного охлаждения и тонкой настройки режимов работы. |

|

Версия PCIe и количество линий |

В 2026 году у AMD и Intel стандартом стал PCIe 5.0 (и уже начался переход на 6 версию). И важно учитывать, сколько линий PCIe, хватит ли их под GPU, NVMe, SmartNIC, DPU и сетевые адаптеры. |

|

Масштабируемость по количеству сокетов |

Для старта подходит 1 сокет — удобно, недорого, энергоэффективно. 2 сокета подходят для умеренных и высоких нагрузок + есть задел для масштабирования. 4 сокета встречаются редко — они нужны в специализированных вычислениях и сложной виртуализации, когда используют огромный объём памяти и сотни ядер. |

Если ситуация у вендоров схожая, что выбрать?

-

Совет по выбору бренда CPU: Выбирайте тот же бренд процессора, на котором уже работает ваша IT-инфраструктура. Монобрендовые системы зачастую работают эффективнее из-за хорошей совместимости. Выстраивайте виртуализацию, опираясь на конкретные функции, которые хотите реализовать, а не из привязки к бренду.

-

Совет по характеристикам CPU: Если вы ограничены в пространстве под IT-инфраструктуру, то берите процессоры с большим количеством ядер и высокой тактовой частотой . Но учитывайте, что они дороже и больше греются. Если же главное — это производительность ВМ, то тактовая частота важнее, чем количество ядер. Чем больше ядер, тем больше виртуалок можно сделать. Для задач с высокой нагрузкой на ядро (VDI, 1С, SQL) в приоритете частота, а не количество ядер. В таких сценариях 16 ядер по 4.0 ГГц дадут выше производительность, чем 64 ядра по 2.5 ГГц.

-

Совет по распределению vCPU (виртуальный процессор с одним ядром): Консервативное правило, которое используют админы — 1 vCPU на 1 виртуальную машину. Не предоставляйте ВМ слишком много vCPU по умолчанию. Во-первых, вы ограничите себя в максимальном количестве виртуальных машин на физическом сервере. Во-вторых, нужно проводить тесты, которые покажут: действительно ли этому приложению нужно несколько ядер; действительно ли оно постоянно использует мощность процессора. Те же SQL-серверы требуют больше ядер, чем почтовые, файловые или радиус серверы.

-

Совет по тестированию ВМ: Спустя неделю-месяц вы увидите закономерности и пиковые нагрузки, которые укажут на слабые места. Тесты помогут избежать высокой конкуренции за ядро, память, сеть и т.д. А также тесты покажут, если процессор(ы) слабо нагружены, и можно разворачивать больше ВМ на хосте.

Оперативная память для сервера виртуализации (RAM)

В 2026 году DDR5 уже стала основным стандартом. DDR4 всё ещё встречается в серверах предыдущих поколений до 2021-2022 года (Xeon Scalable 3, EPYC Milan) и отлично работает там, но для всех новых систем она устарела и не поддерживается.

У сервера должен быть достаточный объем оперативной памяти для ОС/гипервизора, каждой виртуальной машины и приложений , установленных на ВМ. Зачастую памяти для виртуализации нужно много. И лучше иметь запас 30% (можно и больше).

Совет по выбору серверной RAM: Производители брендовых серверов определяют/одобряют конкретных вендоров оперативки, чьи продукты поддерживаются. Вставить первую попавшуюся не получится (за редкими исключениями). Из-за ограниченного выбора сильно не разгуляешься, а глобальной разницы между планками от разных производителей нет. Это скорее вопрос цены, совместимости и надёжности (например, у некоторых есть пожизненная гарантия). Поэтому выбор вендора RAM — не такой важный вопрос, как при выборе процессоров, которые влияют чуть ли не на всю IT-инфраструктуру.

Чек-лист перед выбором серверной памяти (RAM, ОЗУ) для виртуализации

|

Параметр |

Примечание |

|

Тип памяти: DDR4 или DDR5 |

У DDR5 выше частоты, ниже энергопотребление на бит, лучше масштабируется при больших объёмах. Но многие старые платформы работают только с DDR4, поэтому нужно сверять поддержку по CPU и материнской плате. |

|

Частота памяти |

Нормальная частота DDR5 — 4800–6400 МГц (иногда выше), но реальные рабочие частоты иногда ниже (из-за ограничений платформы), чем характеристики планки памяти. Не переплачивайте за высокочастотную память, если сервер не может раскрыть её потенциал. |

|

Тип модулей: RDIMM / LRDIMM / 3DS RDIMM |

RDIMM — универсально; LRDIMM — для большого объёма; 3DS — высокая плотность без увеличенных задержек. Также появились модули MRDIMM (Multiplexed Rank DIMM, иногда называют MR DIMM) — новейший стандарт со скоростью работы до 8800 МГц при меньших задержках и энергопотреблении, по сути это объединение двух модулей DDR 5 RDIMM в один модуль. |

|

Поддержка ECC |

В целом вся современная серверная память поддерживает ECC. Эта технология отлавливает и исправляет ошибки в памяти, что критично для виртуализации, баз данных и кластеров. Если работаете на рабочей станции или ПК, то обращайте внимание на это. |

|

Количество каналов CPU |

Новые платформы (Xeon 6, EPYC Turin) имеют до 12 каналов на сокет. Чем лучше заполнены каналы, тем выше пропускная способность памяти и стабильность при больших объёмах. |

|

Равномерное распределение модулей по каналам |

Неравномерное заполнение каналов снижает пропускную способность. В двухсокетных системах модули нужно распределять симметрично, иначе один сокет будет работать медленнее другого. Контроллер памяти процессора работает подобно RAID 0 для дисков, только с оперативной памятью. |

|

Объём памяти и запас ~30 % |

Запас покрывает всплески использования памяти. Да, современные гипервизоры (vSphere, Proxmox) используют баллонинг (динамичское распределение) и компрессию (сжатие), но эти технологии не решают проблему нехватки памяти — лишь смягчают её. |

|

Проверка совместимости в QVL-листе (Qualified Vendor List) |

Даже модули одного стандарта и от одного производителя могут не подходить к конкретной серверной базе (особенно брендовой, вроде Dell и HPE). QVL-лист даёт гарантированную совместимость, особенно важно сверяться, если выбираете DDR5 и 3DS-модули. |

В таблицу можно было бы добавить пункт про конкретный объём памяти, например, для одной виртуальной машины, но этот параметр кратно различается при разных нагрузках…Поэтому не существует однозначных рекомендаций в этом вопросе. Но самое главное — не допустить нехватки памяти, иначе обделённые ВМ будут чаще обращаться к накопителю, что значительно снизит производительность ОС и приложений. Так что запас в 30% необходим, чтобы гипервизор в пределах ограничений мог динамически распределять доступный объем RAM между виртуалками.

Совет по распределению vRAM: Даже если у хостовой машины большой объем оперативной памяти, не стоит выделять виртуалкам больше, чем требуется. Протестируйте, сколько в действительности нужно пользователю и (или) приложениям для нормальной работы. Например, рядовым пользователям для офисных приложений в Windows 10 или 11 (тот же пакет MS Office), вряд ли понадобится больше 4-8 ГБ оперативной памяти. Если выделите им 16 ГБ — лучше не станет. Тестируйте реальные нагрузки, не выделяйте чрезмерным запасом (это снижает плотность ВМ), для VDI и офисных ВМ хватит 4–8 ГБ, для серверов баз данных или 1С уже 16–32 ГБ памяти и выше. И оставляйте минимум 10–15% памяти хосту под гипервизор и кэширование.

Накопители

Для виртуализации лучше всего подходят SSD, в первую очередь NVMe. Форматы U.3 и E3.S уже вытесняют U.2 и M.2 в серверном сегменте — у них выше плотность, проще обслуживание, стабильнее температурный режим.

Для хостовой ОС и гипервизора (Proxmox, ESXi и другие) разумнее ставить небольшой RAID из нескольких SSD. Если один диск внезапно умрёт, он не утянет за собой рабочие виртуалки. А вот для самих ВМ лучше выделить отдельный высокоскоростной пул — NVMe-массив, Ceph или vSAN. Скорость NVMe раскрывается только на самостоятельном рабочем хранилище.

Почему NVMe, а не SAS SSD? У NVMe задержка минимальна, а пропускная способность в несколько раз выше. Виртуальные машины, базы, сервисы с частыми мелкими запросами реагируют намного стабильнее. Серверные NVMe всё ещё недешёвые, но альтернативы для современной виртуализации, к сожалению, нет. SAS-диски встречаются всё реже, SATA HDD — уже не обсуждается (только для совсем элементарных и некритичных задач). В новых серверах их ставят всё реже: чаще под архив, локальные репозитории резервных копий или холодное хранилище.

Какие накопители выбрать для виртуализации в 2026 году

NVMe SSD (U.2, U.3, E1.S, E3.S) — основной рабочий инструмент. Современные PCIe 4.0/5.0 тянут до 14 ГБ/с, а задержки в разы ниже, чем у SAS.

SAS 12G / 24G (SAS4) — всё ещё можно использовать, но в нишевых сценариях, когда есть мощный RAID-контроллер, плотный массив и необходимость в предсказуемом поведении под линейной нагрузкой. Их доля падает с каждым годом, особенно в новых стоечных конфигурациях (самый популярный формат).

SATA HDD — только архив или бэкапы. Под виртуализацию они больше не подходят. Единственный вариант — временное или архивное хранилище, собранное из старых дисков, которые остались от старого сервера.

Смешанные хранилища (NVMe + SAS HDD)— хороший вариант, чтобы сбалансировать бюджет: горячие данные — на NVMe, всё прочее — на медленном уровне SAS HDD. Но учтите, что смешивание накопителей с разными скоростями (например, HDD и SSD) или разными интерфейсами (например, SATA и NVMe) в одном RAID-массиве (0/1/5/6/10) с блочным чередованием или зеркалирование — это пустая трата ресурсов быстрого диска. Если один диск медленнее — он задерживает завершение операции для всей группы.

Сейчас часто используют программно-определяемые хранилища (SDS), вроде ZFS, Ceph, VMware vSAN и аналоги. В таких системах привычные RAID-уровни переходят в разряд логических схем — всё делается на уровне ПО, а не контроллера.

Сетевой адаптер

У вас может быть любая сеть — локальная, гибридная или публичная. Но один гигабитный порт сегодня уже не подходит виртуализации. Для современных серверов с несколькими ВМ и высокими нагрузками нужно использовать сетевые платы на 2-4 порта по 10 или 25 Гбит (и выше). В корпоративных и дата-центрах уже активно применяют 40 и 100 Гбит, а также тестируют 200, 400 и даже 800. Про это у нас есть отдельный материал на Хабре.

Но важно смотреть не только на количество портов и скорость, но и на функциональные возможности сетевой платы. Поддержка SR-IOV позволяет разделять один физический порт на несколько виртуальных адаптеров, минимизируя нагрузку на CPU и улучшая производительность виртуало. SmartNIC и карты с аппаратным ускорением обработки пакетов дают ещё больше преимуществ для высоконагруженных сред, снижая задержки и ускоряя сетевые операции.

Важна и отказоустойчивость. Одна карта — одна точка отказа. Для небольших и некритичных сред одну карту можно использовать, но для ключевых ВМ уже нужна избыточность на уровне железа. Самый простой способ — добавить дублирующую плату и настроить агрегацию каналов (LACP) или бондинг (объединение нескольких сетевых интерфейсов в одну виртуальную интерфейсную группу). Так вы получите непрерывную работу даже при выходе из строя одного порта. В современных средах часто используют комбинацию нескольких методов: резервные NIC, многопортовые карты с SR-IOV, виртуальные сетевые адаптеры в гипервизоре и VLAN-разделение, что позволяет повысить и пропускную способность, и устойчивость инфраструктуры.

Если нагрузки небольшие, можно ограничиться одним портом с резервной картой, но если у вас крупные виртуальные среды, потоковые сервисы или вычисления с интенсивной передачей данных, то от сетевых адаптеров будет зависеть работа всей инфраструктуры.

В этой статье я поговорил о физическом сервере для виртуализации, но не менее важный аспект — правильно подобрать и настроить софт. Однако тема настолько обширная, что не уместилась бы в рамки этой статьи.

Подытожим: не всем подходит хостинг, поэтому они выбирают собственный сервер для виртуализации. Иногда под эту задачу адаптируют уже существующую инфраструктуру. Она либо не подходила изначально, либо устарела со временем, что становится проблемой.

Если бюджет не позволяет взять новые серверы, есть способ сэкономить — купить восстановленные серверы Dell, HPE и Lenovo. Они в среднем дешевле на 30%, но показывают отличную производительность и надёжность, а мы дадим гарантию 5 лет. Если у вас остались вопросы, задавайте нашим менеджерам.

Нажимая кнопку «Отправить», я даю согласие на обработку и хранение персональных данных и принимаю соглашение