В дата-центрах обычно ничего не стоит на месте - стандартной является ситуация, когда определенные функции переводят с одного компонента на другой в целях экономии или повышения производительности. Именно это произошло с сетевыми функциями: изначально они были на отдельных устройствах, затем в эпоху программно-определяемых сетей (SDN) стараниями Intel перекочевали на центральные процессоры (CPU), потом переместились на SmartNIC и DPU. Теперь же часть функций снова возвращается в коммутаторы - именно об этом сегодня пойдет речь.

Коммутаторы с DPU

Три года назад сетевое подразделение Aruba компании Hewlett Packard Enterprise (HPE) начало устанавливать DPU (Data Processing Unit) от Pensando (подразделение AMD) в свои корпоративные коммутаторы CX1000. Конкурент Cisco Systems пошел тем же путем в феврале этого года со своими коммутаторами Nexus N9300, объединив свой Ethernet-чип Silicon One E100 ASIC с четырьмя DPU Pensando Elba второго поколения (или двумя DPU Giglio Gen 2+).

DPU Elba с двумя портами 200 Гбит/с был представлен в 2021 году, а DPU Giglio вышел двумя годами позже, также с двумя портами 200 Гбит/с, но при этом отличаясь сниженным энергопотреблением при более высокой производительности. Оба этих DPU были произведены по 7-нм техпроцессу компании TSMC. Они содержат 144 специализированных MPU (match processing unit), работающих на частоте 2 ГГц для обработки алгоритмов P4. Также, вычислительные возможности дополняются шестнадцатью ядрами Arm A72, работающими на частоте 3 ГГц.

В DPU третьего поколения Pensando Salina (которые официально еще не анонсированы, хотя и значились в дорожной карте на конец 2024 года), Pensando переходит на 5-нм техпроцесс TSMC и таким образом повышает производительность примерно в 2 раза. Эти DPU оснащены двумя портами 400 Гбит/с, 232 MPU и шестнадцатью ядрами Arm Neoverse Ares N1.

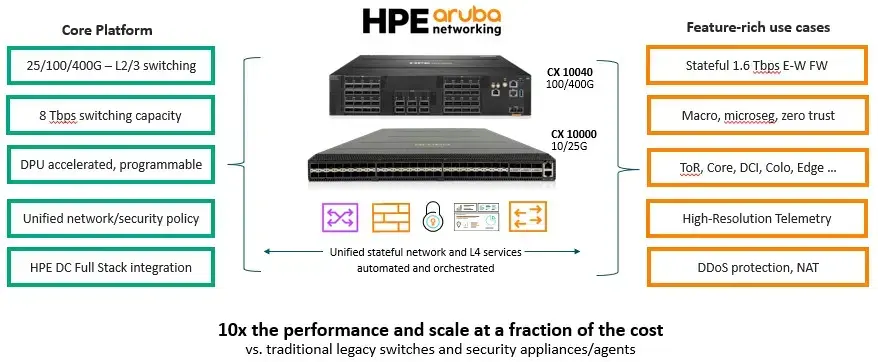

В гибридных коммутаторах CX 10000 с DPU, представленных подразделением HPE Aruba три года назад, использовались не Ethernet-ASIC HPE, а коммутаторные чипы Trident3 StrataXGS от Broadcom с пропускной способностью 3.2 Тбит/с. В CX 10000 был встроен шестиядерный процессор Intel Xeon D-1637 для локальных вычислений (с 32 ГБ оперативной памяти DRAM и 64 ГБ флеш-памяти для хранилища CPU) и пара DPU Elba. Получившийся расширенный коммутатор имел 48 downlink портов со скоростью 25 Гбит/с (идеально подходящих для серверов средней мощности) и шесть uplink портов со скоростью 100 Гбит/с.

Характеристики коммутатора CX10040

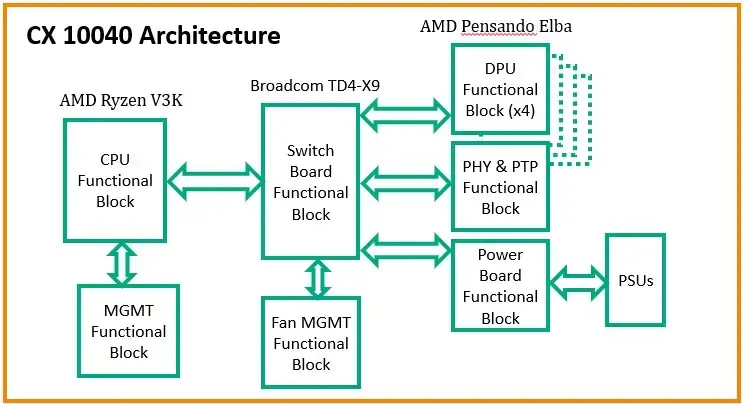

С новой моделью CX 10040 все обстоит несколько иначе - она обладает более высокой пропускной способностью и большей мощностью DPU. Ниже представлена схема, отражающая архитектуру CX 10040:

В основе устройства лежит ASIC Trident4-X9 от Broadcom с пропускной способностью 8 Тбит/с, дополненный встроенным процессором AMD Ryzen V3000 в качестве сопроцессора. Коммутатор располагает четырьмя DPU Elba, 48 downlink портами со скоростью 100 Гбит/с и шестью uplink портами по 400 Гбит/с.

При этом, нельзя не упомянуть, что Cisco реализовала кастомный коммутаторный проект с рядом гиперскейлеров и облачных провайдеров, разместив восемь DPU Elba вокруг Ethernet-ASIC Silicon One Q200L с пропускной способностью 12.8 Тбит/с. Учитывая относительную нехватку пропускной способности у ASIC Silicon One – ведь мы живем в эпоху устройств на 51.2 Тбит/с, а вскоре ожидаем 102.4 Тбит/с в облачных дата-центрах – пропускная способность в 8 Тбит/с у CX 10040 не выглядит впечатляюще. Однако, определенно стоит следить за тем, насколько распространенными станут гибриды DPU-коммутаторов, потому что установить два, четыре или восемь DPU в коммутатор гораздо дешевле, чем установить по одному в десятки или сотни серверов. В целом, большинство предприятий или облачных провайдеров не хотят вскрывать свой парк серверов, чтобы добавить сетевые карты (NIC) или DPU. Помещать DPU на уровне агрегации сети (uplink/aggregation) пока не имеет большого смысла (по крайней мере, сейчас), и для этого Aruba рекомендует свой CX 9300. Это устройство с фиксированными портами в форм-факторе 1U, имеющее 32 порта со скоростью 100 Гбит/с, 200 Гбит/с или 400 Гбит/с, с пропускной способностью 25.6 Тбит/с (способно обрабатывать 5 миллиардов пакетов в секунду).

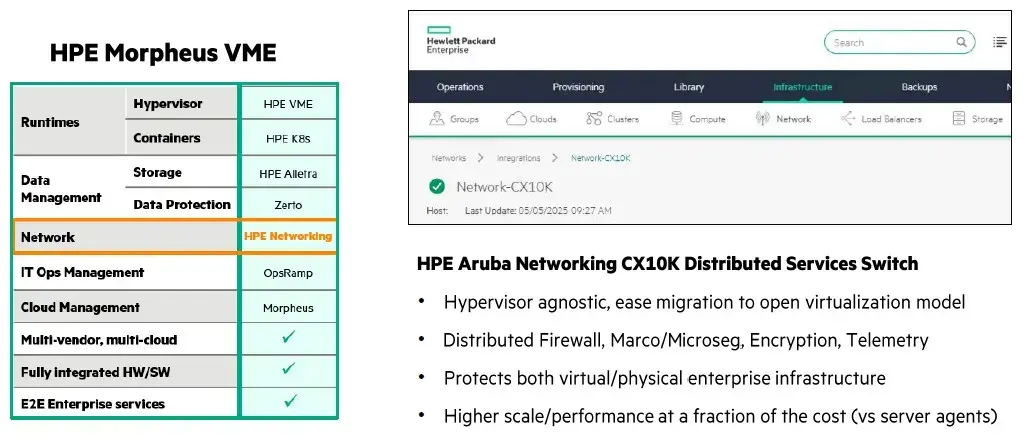

Как HPE предлагает альтернативу VMware

HPE не любит термин «умный коммутатор» (smart switch), и предпочитает называть серию CX 10000 семейством коммутаторов «распределенных сервисов» (distributed services switches). Важный момент с точки зрения корпоративных клиентов заключается в том, что HPE может заменить гипервизор VMware ESXi своей вариацией Morpheus VM Essentials (VME) на базе гипервизора KVM с открытым исходным кодом и использовать распределенный межсетевой экран, микросегментацию, шифрование и телеметрию в коммутаторах CX 10000 и 10040 для замены функций виртуальных сетей VMware NSX.

Broadcom, без сомнения, может быть доволен тем, что HPE использует его ASIC, но определенно не будет рад тому, что HPE предлагает альтернативу VMware. Но это бизнес — ничего личного.

Выгоды от использования коммутаторов с DPU

Изменения в корпоративных дата-центрах происходят медленно. Чтобы продемонстрировать ценность SmartNIC и DPU, понадобился интерес крупных корпораций - Microsoft, Amazon Web Services и Google. Также, высокая стоимость стареющего парка дорогих сетевых устройств безопасности в дата-центре дополнительно способствует развитию бизнеса DPU. Коммутатор CX 10000 или 10040 заданной емкости может значительно снизить стоимость межсетевых экранов и других устройств безопасности, обеспечивая при этом примерно 10-кратную производительность. В конфигурации с 500 серверами, защищаемыми аппаратными межсетевыми экранами (firewall appliances) и использующими стандартные коммутаторы Ethernet, было подсчитано, что трехлетняя стоимость такой установки составляет 2.7 млн долларов. Общая пропускная способность в 8.4 Тбит/с для 24 серверных стоек потребовала бы восемь физических межсетевых экранов и два коммутатора ToR на стойку. При использовании 48 коммутаторов CX 10000 и программных межсетевых экранов, работающих на DPU, цена снижается до 1.05 млн долларов.

Как сообщается, коммутатор CX 10040 будет доступен в конце июня или начале июля.

Нажимая кнопку «Отправить», я даю согласие на обработку и хранение персональных данных и принимаю соглашение